مدلهای ترنسفورمر (Transformers) در حوزه پردازش زبانهای طبیعی (NLP) به دلیل قابلیتهای بینظیرشان در درک و تولید زبان، انقلابی در هوش مصنوعی پدید آوردهاند. این مدلها با تکیه بر مکانیزم توجه (Attention Mechanism)، توانستهاند محدودیتهای مدلهای قبلی مانند شبکههای عصبی بازگشتی (RNN) را پشت سر بگذارند و راه را برای توسعه مدلهای زبان بزرگ (LLMs) هموار کنند.

در دنیای امروز که دادههای متنی با سرعت سرسامآوری در حال تولید هستند، نیاز به ابزارهایی برای تحلیل، تفسیر و تولید هوشمندانه زبان بیش از پیش احساس میشود. مدلهای ترنسفورمر (Transformer) دقیقاً به همین منظور طراحی شدهاند و با معماری پیشرفته خود، توانایی پردازش موازی اطلاعات و مدیریت وابستگیهای دوربرد در توالیهای متنی را فراهم میآورند. در این گزارش، به بررسی عمیق معماری، اجزا، مزایا و کاربردهای این مدلهای پیشرو در عرصه هوش مصنوعی خواهیم پرداخت تا تصویری جامع از عملکرد آنها ارائه دهیم و نشان دهیم که چرا آموزش nlp و به ویژه آموزش nlp مجتمع فنی تهران با تمرکز بر این مدلها، برای متخصصان امروز و آینده اهمیت فراوانی دارد.

انقلاب Attention در پردازش زبان طبیعی (NLP)

پردازش زبانهای طبیعی (NLP) شاخهای حیاتی در هوش مصنوعی است که به ماشینها امکان میدهد زبان انسان را درک کرده، تفسیر و تولید کنند. این حوزه در سالیان اخیر پیشرفتهای چشمگیری داشته و نقش کلیدی در توسعه دستیارهای صوتی، ترجمه ماشینی، تحلیل احساسات و بسیاری دیگر از کاربردهای روزمره ایفا میکند. اما تا چند سال پیش، مدلهای رایج مانند شبکههای عصبی بازگشتی (RNN)، LSTM و GRU با چالشهای اساسی در پردازش توالیهای طولانی و عدم توانایی در موازیسازی روبرو بودند.

این محدودیتها، نیاز به یک معماری جدید را برجسته ساخت. در سال ۲۰۱۷، با انتشار مقاله “Attention Is All You Need”، مدل ترنسفورمر معرفی شد و نقطه عطفی تاریخی در NLP رقم خورد. این مدل با کنار گذاشتن رویکردهای ترتیبی (sequential) و اتکا کامل به مکانیزم توجه (Attention Mechanism)، توانست پردازش موازی را ممکن ساخته و مشکلات وابستگیهای بلندمدت را به طرز چشمگیری بهبود بخشد. از آن زمان، ترنسفورمرها به سرعت محبوب شدند و به موتور محرکه نسل جدید مدلهای زبان بزرگ مانند BERT و GPT تبدیل گشتهاند.

مدل ترنسفورمر (Transformer) چیست؟

مدل ترنسفورمر یک معماری شبکه عصبی پیشرفته است که به طور کامل بر پایه مکانیزم توجه (Attention Mechanism) بنا شده است. برخلاف مدلهای قبلی که اطلاعات را به صورت ترتیبی و گام به گام پردازش میکردند، ترنسفورمر قادر است تمام بخشهای یک توالی ورودی را به طور همزمان مورد توجه قرار دهد. این قابلیت به مدل اجازه میدهد تا روابط پیچیده بین کلمات، حتی در فواصل دوردست را به خوبی درک کند و عملکردی بینظیر در وظایف مختلف NLP ارائه دهد.

تاریخچه کوتاه این مدل نشان میدهد که از زمان معرفیاش، به سرعت به استاندارد صنعتی برای توسعه مدلهای زبان بزرگ (LLMs) تبدیل شده است. مکانیزم توجه، هسته اصلی ترنسفورمر است و به آن اجازه میدهد تا بر بخشهای مرتبط و مهم ورودی تمرکز کند، دقیقا شبیه به چشمان انسان که هنگام خواندن یک جمله، به کلمات کلیدی و مهمتر توجه بیشتری نشان میدهند.

برای افرادی که به دنبال دوره آموزش nlp حرفه ای هستند، درک عمیق این مکانیزمها یک گام اساسی محسوب میشود. این مدل به جای اینکه یک کلمه را پس از دیگری بخواند، به تمام کلمات جمله به صورت همزمان نگاه میکند و با محاسبه اهمیت نسبی هر کلمه برای کلمه دیگر، معنای دقیقتری از کل جمله استخراج میکند. این رویکرد، پایه و اساس قدرت بینظیر ترنسفورمرها در درک زبان است.

مدلهای ترنسفورمر با تکیه بر مکانیزم توجه، توانایی پردازش موازی اطلاعات و مدیریت وابستگیهای دوربرد در توالیهای متنی را فراهم میآورند و انقلابی در پردازش زبان طبیعی پدید آوردهاند.

ساختار کلی معماری ترنسفورمر: نگاهی جامع

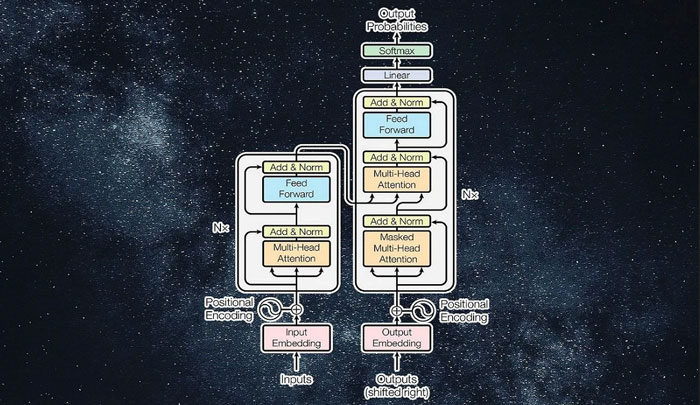

معماری ترنسفورمر به طور کلی از دو بخش اصلی تشکیل شده است: یک انکودر (Encoder) و یک دیکودر (Decoder). هر یک از این بخشها خود شامل چندین بلاک مشابه هستند که به صورت پشتهای روی هم قرار گرفتهاند. در مقاله اصلی “Attention Is All You Need”، از ۶ بلاک انکودر و ۶ بلاک دیکودر استفاده شده است، اما تعداد آنها میتواند بسته به پیچیدگی وظیفه و حجم دادهها متفاوت باشد.

انکودر وظیفه دارد تا توالی ورودی (مثلاً یک جمله) را دریافت کرده و آن را به یک نمایش برداری غنی از معنا تبدیل کند. دیکودر نیز این نمایش برداری را به همراه خروجیهای تولید شده در گامهای قبلی دریافت میکند و توالی خروجی (مثلاً ترجمه جمله) را کلمه به کلمه تولید میکند. ورودی این مدلها شامل Embeddings (تعبیه کلمات) است که کلمات را به بردارهای عددی تبدیل میکند و Positional Encoding (انکودینگ موقعیتی) که اطلاعات مربوط به ترتیب کلمات را به مدل منتقل میکند.

بخش انکودر (Encoder): درک و کدگذاری ورودی

هر بلاک انکودر در مدل ترنسفورمر مسئول پردازش و درک بخشی از توالی ورودی است. این بخش قلب پردازش اطلاعات اولیه را تشکیل میدهد و برای هر کسی که به دنبال آموزش پردازش زبان طبیعی در هوش مصنوعی است، شناخت دقیق آن ضروری است.

ورودی انکودر

- Word Embeddings (تعبیه کلمات): اولین گام در پردازش کلمات، تبدیل آنها به بردارهای عددی است که برای مدل قابل فهم باشند. این بردارها، کلمات با معنای مشابه را در فضای برداری به هم نزدیک میکنند.

- Positional Encoding (انکودینگ موقعیتی): از آنجایی که ترنسفورمر کلمات را به صورت موازی پردازش میکند، اطلاعات مربوط به ترتیب کلمات از دست میرود. انکودینگ موقعیتی با افزودن بردارهای موقعیتی به بردارهای تعبیه کلمات، این اطلاعات حیاتی را به مدل برمیگرداند. این بردارها معمولاً از توابع سینوسی و کسینوسی با فرکانسهای مختلف برای نمایش موقعیت هر کلمه در توالی استفاده میکنند، به طوری که مدل بتواند موقعیت نسبی کلمات را درک کند.

اجزای داخلی هر بلاک انکودر

هر بلاک انکودر شامل دو زیرلایه اصلی است که هر کدام با اتصالات باقیمانده (Residual Connections) و نرمالسازی لایهای (Layer Normalization) ترکیب شدهاند:

- Multi-Head Self-Attention (توجه چند سر خودی): این لایه هسته اصلی انکودر را تشکیل میدهد.

- مفهوم Self-Attention: به مدل اجازه میدهد تا در حین پردازش یک کلمه، به تمام کلمات دیگر جمله نیز توجه کند و ارتباط معنایی آنها را با کلمه فعلی بسنجد. این مکانیزم به مدل کمک میکند تا “با” را در “من با دوست خود به سینما رفتم” به “دوست” ربط دهد، حتی اگر این کلمات از هم دور باشند.

- Query, Key, Value (Q, K, V): برای درک Self-Attention، هر کلمه ورودی به سه بردار Query، Key و Value تبدیل میشود. Query مانند یک “پرسش” است که مدل با آن به دنبال کلمات مرتبط میگردد. Key مانند “برچسب” کلمات دیگر است که برای پاسخ به Query استفاده میشود. Value نیز “محتوای” کلمه را نمایندگی میکند.

- مکانیزم Scaled Dot-Product Attention: این مکانیزم نحوه محاسبه امتیاز توجه را نشان میدهد. در اینجا، هر Query با تمامی Keyها ضرب داخلی میشود تا امتیاز توجه بین کلمه فعلی و سایر کلمات به دست آید. این امتیازات سپس مقیاسبندی شده و از طریق تابع سافتمکس به احتمالات تبدیل میشوند و در نهایت با Valueها ضرب میشوند تا یک بردار خروجی وزندهی شده تولید شود.

- Multi-Head Attention: به جای استفاده از یک مکانیزم توجه، ترنسفورمر از چندین “سر” توجه موازی (Multi-Head) استفاده میکند. هر سر به جنبههای مختلف رابطه بین کلمات توجه میکند و این تنوع در توجه، توانایی مدل را در درک پیچیدگیهای معنایی افزایش میدهد. خروجی این سرها در نهایت به هم پیوسته و به لایه بعدی منتقل میشود.

- Feed-Forward Neural Network (شبکه عصبی پیشخور): پس از لایه توجه، اطلاعات استخراج شده از طریق یک شبکه عصبی پیشخور سادهتر پردازش میشوند. این لایه به مدل کمک میکند تا الگوهای پیچیدهتر را از اطلاعات جمعآوری شده توسط توجه استخراج کند.

- Residual Connections و Layer Normalization: اتصالات باقیمانده به جریان داده کمک میکنند تا به راحتی از لایهها عبور کرده و مشکل ناپدید شدن گرادیان (vanishing gradient) را کاهش میدهند. نرمالسازی لایهای نیز به پایداری آموزش مدل و سرعت همگرایی آن کمک میکند.

بخش دیکودر (Decoder): تولید هوشمندانه خروجی

دیکودر در معماری ترنسفورمر وظیفه تولید توالی خروجی را بر عهده دارد و به نوعی مکمل کار انکودر است. درک نحوه عملکرد این بخش، گامی مهم در تسلط بر دوره آموزش nlp و کاربردهای آن محسوب میشود.

ورودی دیکودر

دیکودر در هر گام زمانی، کلمات تولید شده در گامهای قبلی را به عنوان ورودی دریافت میکند. همانند انکودر، این کلمات نیز ابتدا به Embeddings و سپس با افزودن Positional Encoding، به بردارهای ورودی برای دیکودر تبدیل میشوند تا اطلاعات موقعیتی آنها حفظ شود.

اجزای داخلی هر بلاک دیکودر

هر بلاک دیکودر نیز از اتصالات باقیمانده و نرمالسازی لایهای بهره میبرد و شامل سه زیرلایه اصلی است:

- Masked Multi-Head Self-Attention (توجه چند سر خودی با پوشش):

- تفاوت با Self-Attention انکودر: این لایه شبیه به Self-Attention در انکودر عمل میکند، اما با یک تفاوت حیاتی. در زمان تولید کلمه فعلی، دیکودر نباید به کلمات آینده در توالی خروجی “نگاه کند” (Look-ahead). برای جلوگیری از این اتفاق، مکانیزم Masking (پوشاندن) به کار میرود.

- نحوه عملکرد Masking: در این فرآیند، امتیازات توجه برای کلمات آینده به صفر یا مقادیر بسیار کوچک (منفی بینهایت) تنظیم میشوند تا تأثیری در تصمیمگیری مدل برای تولید کلمه فعلی نداشته باشند. این کار تضمین میکند که تولید خروجی به صورت خودبازگشتی و مرحله به مرحله انجام شود.

- Encoder-Decoder Attention (Cross-Attention):

- ارتباط با انکودر: این لایه، ارتباط حیاتی بین انکودر و دیکودر را برقرار میکند. در اینجا، Query از خروجی لایه Self-Attention دیکودر میآید، در حالی که Key و Value از خروجی نهایی انکودر تامین میشوند.

- نقش این لایه: Cross-Attention به دیکودر این امکان را میدهد که هنگام تولید هر کلمه خروجی، بر قسمتهای مرتبط توالی ورودی که توسط انکودر کدگذاری شدهاند، تمرکز کند. این مکانیزم تضمین میکند که دیکودر اطلاعات لازم از جمله ورودی را برای تولید خروجی صحیح در اختیار داشته باشد.

- Feed-Forward Neural Network: مانند انکودر، یک لایه شبکه عصبی پیشخور نیز در دیکودر وجود دارد که اطلاعات استخراج شده را بیشتر پردازش میکند.

نحوهی تولید نهایی خروجی در ترنسفورمر

پس از اینکه دیکودر آخرین بردار پردازش شده را تولید کرد، این بردار باید به یک کلمه قابل فهم برای انسان تبدیل شود. این فرآیند از طریق دو لایه پایانی انجام میگیرد.

- Linear Layer (لایه خطی): این لایه یک شبکه عصبی کاملاً متصل است که بردار خروجی نهایی از دیکودر را دریافت کرده و آن را به یک بردار بزرگتر به نام “Logits” تبدیل میکند. اندازه این بردار برابر با تعداد کل کلماتی است که مدل در واژگان خود دارد (مثلاً ۲۰,۰۰۰ کلمه). هر یک از سلولهای Logits، یک امتیاز خام برای احتمال هر کلمه در واژگان برای گام فعلی خروجی را نشان میدهد.

- Softmax Layer (لایه سافتمکس): لایه سافتمکس وظیفه تبدیل این امتیازات خام (Logits) به توزیع احتمال بر روی تمامی کلمات واژگان را بر عهده دارد. خروجی سافتمکس، اعدادی بین ۰ و ۱ هستند که مجموع آنها برابر با ۱ میشود و احتمال انتخاب هر کلمه را نشان میدهند. کلمهای که بالاترین احتمال را دارد، به عنوان کلمه خروجی برای گام زمانی فعلی انتخاب میشود.

فرایند تولید توالی (Sequence Generation): تولید توالی در دیکودر به صورت تکراری و گام به گام اتفاق میافتد. دیکودر ابتدا توکن شروع (Start-of-Sequence) را دریافت میکند و با کمک اطلاعات انکودر، اولین کلمه خروجی را پیشبینی میکند. سپس، این کلمه تولید شده به همراه توکن شروع، به عنوان ورودی برای تولید کلمه بعدی به دیکودر بازگردانده میشوند. این فرآیند تا زمانی ادامه مییابد که مدل توکن پایان (End-of-Sequence) را تولید کند، که نشاندهنده اتمام توالی خروجی است.

مزایای کلیدی و چرایی جایگزینی ترنسفورمرها

مدلهای ترنسفورمر به دلایل متعددی توانستند جایگزین بسیاری از مدلهای پیشین در NLP شوند و در بسیاری از موارد عملکرد بهتری ارائه دهند. این مزایا، اهمیت دوره آموزش nlp حرفه ای و آموزش nlp مجتمع فنی تهران را برای ورود به این حوزه برجسته میسازد.

- Parallelization (موازیسازی): یکی از بزرگترین مزیتهای ترنسفورمرها، قابلیت پردازش همزمان تمام ورودیها است. این در حالی است که مدلهای RNN و LSTM به دلیل ماهیت ترتیبی خود، مجبور بودند کلمات را یکی پس از دیگری پردازش کنند. موازیسازی باعث افزایش چشمگیر سرعت آموزش و استنتاج (inference) مدلهای ترنسفورمر میشود.

- Handling Long-Range Dependencies (مدیریت وابستگیهای دوربرد): مدلهای RNN/LSTM در توالیهای بسیار طولانی با مشکل “فراموشی” اطلاعات اولیه روبرو بودند. مکانیزم توجه در ترنسفورمر به مدل اجازه میدهد تا به تمامی کلمات ورودی، صرف نظر از فاصله آنها، به طور مستقیم توجه کند و این مشکل را به طور موثری حل میکند. این توانایی در آموزش پردازش زبان طبیعی در هوش مصنوعی بسیار حیاتی است.

- Performance (عملکرد): ترنسفورمرها در بسیاری از وظایف NLP مانند ترجمه ماشینی، خلاصهسازی متن، و پاسخگویی به سوالات، به دلیل تواناییهای پیشرفته خود در درک معنا و روابط کلمات، به نتایج بیسابقهای دست یافتهاند و دقت و کیفیت خروجی را به شکل قابل توجهی بهبود بخشیدهاند.

- Transfer Learning (یادگیری انتقالی): ساختار ترنسفورمر امکان آموزش مدلهای بسیار بزرگ بر روی حجم عظیمی از دادههای متنی (pre-training) و سپس تنظیم دقیق آنها (fine-tuning) برای وظایف خاص با دادههای کمتر را فراهم میکند. این رویکرد که به یادگیری انتقالی معروف است، باعث کاهش چشمگیر زمان و منابع مورد نیاز برای آموزش مدلهای جدید میشود و منجر به ظهور مدلهای پیشآموزشدیده قدرتمندی مانند BERT و GPT شده است.

به طور خلاصه، تواناییهای این مدلها در پردازش کارآمد و عمیق زبان، آنها را به یک ستاره در میان الگوریتمهای هوش مصنوعی تبدیل کرده است. به همین دلیل، تسلط بر آموزش nlp و به خصوص دوره آموزش nlp حرفه ای برای هر توسعهدهنده و محققی که به دنبال پیشرفت در این حوزه است، ضروری به شمار میآید.

کاربردها و مدلهای مبتنی بر ترنسفورمر

مدلهای ترنسفورمر و مدلهای مبتنی بر آنها، طیف وسیعی از کاربردها را در دنیای واقعی متحول کردهاند. آشنایی با این کاربردها برای هر کسی که در آموزش پردازش زبان طبیعی در هوش مصنوعی مشارکت دارد، بسیار مهم است.

| کاربرد اصلی | شرح | مدلهای مرتبط |

|---|---|---|

| ترجمه ماشینی | ترجمه متون از یک زبان به زبان دیگر با دقت و روانی بالا. | Transformer, Google Translate (مبتنی بر ترنسفورمر) |

| خلاصهسازی متن | تولید خلاصههای مختصر و مفید از متون طولانی. | BART, T5 |

| تولید متن و چتباتها | تولید محتوای متنی خلاقانه، پاسخ به سوالات در چتباتها. | GPT (GPT-2, GPT-3, GPT-4), LaMDA |

| پاسخگویی به سوالات | استخراج پاسخ دقیق از یک متن یا پایگاه دانش. | BERT, RoBERTa |

| تحلیل احساسات | تشخیص لحن و احساسات (مثبت، منفی، خنثی) در متون. | BERT, XLNet |

| بازشناسی گفتار (Speech Recognition) | تبدیل گفتار به متن و بالعکس. | Whisper |

مدلهای معروف دیگری نیز وجود دارند که بر پایه ترنسفورمر ساخته شدهاند و هر یک در زمینههای خاص خود تواناییهای چشمگیری دارند. به عنوان مثال:

- BERT (Bidirectional Encoder Representations from Transformers): این مدل توسط گوگل توسعه یافته و به دلیل تواناییاش در درک عمیقتر از معنای کلمات با توجه به بافت دوطرفه (هم کلمات قبل و هم کلمات بعد)، در وظایف پاسخگویی به سوالات و تحلیل متنی بسیار قدرتمند است. دوره آموزش nlp معمولاً به تفصیل به این مدل میپردازد.

- GPT (Generative Pre-trained Transformer): سری مدلهای GPT توسط OpenAI توسعه یافتهاند و در تولید متن، چتباتها و ایجاد محتوای خلاقانه شهرت دارند. از GPT-2 تا GPT-4 و مدلهای پیشرفتهتر، این خانواده از ترنسفورمرها مرزهای تولید زبان را جابجا کردهاند.

- T5 (Text-to-Text Transfer Transformer): این مدل هر وظیفه NLP را به یک مسئله “تبدیل متن به متن” تبدیل میکند و انعطافپذیری بالایی در انجام کارهای مختلف دارد.

اهمیت این مدلها به حدی است که یادگیری و کار با آنها، به یکی از مهمترین مهارتها در حوزه هوش مصنوعی تبدیل شده است. از همین رو، مراکزی مانند مجتمع فنی تهران با ارائه دوره آموزش nlp حرفه ای، نقش حیاتی در تربیت متخصصان این حوزه ایفا میکنند.

چالشها و محدودیتهای مدلهای ترنسفورمر

با وجود تمام مزایا و قدرت مدلهای ترنسفورمر، این معماری بینقص نیست و با چالشها و محدودیتهایی نیز روبرو است که شناخت آنها برای هر متخصص آموزش nlp ضروری است.

- مصرف بالای منابع محاسباتی: آموزش و اجرای مدلهای ترنسفورمر، به ویژه مدلهای بزرگ (مانند GPT-3)، به قدرت پردازشی فوقالعادهای نیاز دارد. این مدلها نیازمند پردازندههای گرافیکی (GPU) یا واحدهای پردازش تنسور (TPU) پیشرفته و حافظه بسیار زیاد هستند که این موضوع میتواند هزینهبر و دسترسی به آنها برای همه مقدور نباشد.

- نیاز به حجم عظیمی از دادههای آموزشی: برای رسیدن به عملکرد مطلوب، مدلهای ترنسفورمر به حجم بسیار زیادی از دادههای متنی برای آموزش نیاز دارند. جمعآوری و پیشپردازش این حجم از دادهها میتواند یک چالش بزرگ باشد.

- مقیاسپذیری در توالیهای بسیار بلند: هرچند ترنسفورمرها در مدیریت وابستگیهای دوربرد بهتر از RNNها عمل میکنند، اما با افزایش طول توالی ورودی، پیچیدگی محاسباتی مکانیزم توجه به صورت درجه دوم رشد میکند. این موضوع باعث میشود که پردازش توالیهای بسیار بلند (مانند یک کتاب کامل) همچنان چالشبرانگیز باشد. راهحلهایی مانند Longformer یا Reformer با مکانیزمهای توجه اسپارس (Sparse Attention) تلاش کردهاند تا این محدودیت را کاهش دهند.

- تفسیرپذیری (Interpretability): مانند بسیاری از مدلهای یادگیری عمیق، درک دقیق اینکه ترنسفورمر چگونه به یک تصمیم خاص میرسد یا چگونه وزنهای توجه را محاسبه میکند، دشوار است. این “جعبه سیاه” بودن، میتواند در کاربردهای حساس که نیاز به شفافیت و قابلیت توضیح دارند، مشکلساز باشد.

این محدودیتها، حوزه تحقیقاتی فعال و پویایی را برای بهبود و بهینهسازی مدلهای ترنسفورمر ایجاد کرده است. متخصصان آموزش nlp مجتمع فنی تهران و سایر مراکز آموزشی، همواره به روزرسانیهای جدید در این زمینه را دنبال میکنند تا جدیدترین دانش را به دانشجویان خود منتقل نمایند.

آینده ترنسفورمرها در NLP و فراتر از آن

مدلهای ترنسفورمر تنها آغاز راه هستند. تحقیقات فعال و نوآوریهای مستمر در حال تغییر و تکامل این معماری هستند. تکامل معماری ترنسفورمر در سالهای اخیر شتاب فراوانی گرفته است. پژوهشگران در حال بررسی روشهایی برای کاهش مصرف منابع محاسباتی، افزایش کارایی در توالیهای طولانیتر و بهبود تفسیرپذیری این مدلها هستند. معماریهای جدیدی مانند Perceiver و Vision Transformers (ViT) نشان دادهاند که اصول ترنسفورمر میتواند به حوزههایی فراتر از NLP نیز گسترش یابد.

گسترش کاربردها به حوزههای دیگر، یکی از هیجانانگیزترین جنبههای آینده ترنسفورمرهاست. Vision Transformers در حال حاضر در بینایی کامپیوتر (Computer Vision) عملکرد بسیار خوبی از خود نشان داده و در برخی موارد حتی از شبکههای عصبی پیچشی (CNN) نیز پیشی گرفتهاند. این مدلها به جای پردازش تصاویر به عنوان پیکسلهای خام، آنها را به “توکن”های بصری تقسیم کرده و سپس با مکانیزم توجه، روابط بین این توکنها را درک میکنند. همچنین، تحقیقاتی برای استفاده از ترنسفورمرها در پردازش دادههای صوتی، بیولوژیکی (مانند تحلیل توالیهای DNA و پروتئین) و حتی در رباتیک در جریان است. این روند نشان میدهد که اصول توجه، یک مکانیزم یادگیری عمومی و بسیار قدرتمند است که میتواند در حل مسائل پیچیده در دادههای مختلف کارآمد باشد.

با توجه به سرعت تحولات در این حوزه، اهمیت دوره آموزش nlp و آموزش nlp مجتمع فنی تهران برای همگام شدن با جدیدترین پیشرفتها بیش از پیش احساس میشود. این دورهها نه تنها مبانی را آموزش میدهند، بلکه دانشجویان را با مدلهای پیشرفته و کاربردهای نوین آنها آشنا میسازند تا بتوانند در آینده هوش مصنوعی نقش فعالی ایفا کنند. این انقلاب، نویدبخش آیندهای است که در آن ماشینها با درک عمیقتر از جهان پیرامون، میتوانند به شیوههای بیسابقهای با انسانها تعامل داشته باشند.

سوالات متداول

تفاوت اصلی معماری ترنسفورمر با شبکههای عصبی بازگشتی (RNN و LSTM) در چیست؟

ترنسفورمرها برخلاف RNN و LSTM، به جای پردازش ترتیبی، تمام ورودی را به صورت موازی پردازش میکنند و از مکانیزم توجه برای درک روابط دوربرد استفاده میکنند.

مکانیزم “Multi-Head Attention” چه مزیتی نسبت به یک “Self-Attention” ساده دارد؟

Multi-Head Attention به مدل اجازه میدهد تا به طور همزمان به جنبههای مختلف رابطه بین کلمات توجه کند و اطلاعات غنیتر و متنوعتری را استخراج نماید.

“Positional Encoding” چگونه به مدل ترنسفورمر کمک میکند تا ترتیب کلمات را درک کند، با وجود اینکه پردازش ورودی موازی است؟

Positional Encoding بردارهای عددی خاصی را به بردارهای تعبیه کلمات اضافه میکند که حاوی اطلاعات موقعیت کلمه در توالی هستند و به مدل اجازه میدهند ترتیب را درک کند.

چرا در لایه Masked Multi-Head Self-Attention در دیکودر از “Masking” استفاده میشود؟

Masking از “نگاه به آینده” (Look-ahead) مدل در زمان تولید توالی جلوگیری میکند و تضمین میکند که دیکودر فقط بر کلمات قبلی و فعلی تمرکز کند.

آیا مدلهای ترنسفورمر فقط برای پردازش زبان طبیعی کاربرد دارند یا میتوانند در حوزههای دیگری نیز به کار گرفته شوند؟

خیر، ترنسفورمرها به حوزههایی مانند بینایی کامپیوتر (Vision Transformers)، پردازش صدا و حتی بیوانفورماتیک نیز گسترش یافتهاند و در حال نشان دادن تواناییهای چشمگیری هستند.

آیا شما به دنبال کسب اطلاعات بیشتر در مورد "آشنایی با مدل های ترنسفورمر (Transformers) در NLP" هستید؟ با کلیک بر روی آموزش, کسب و کار ایرانی، به دنبال مطالب مرتبط با این موضوع هستید؟ با کلیک بر روی دسته بندی های مرتبط، محتواهای دیگری را کشف کنید. همچنین، ممکن است در این دسته بندی، سریال ها، فیلم ها، کتاب ها و مقالات مفیدی نیز برای شما قرار داشته باشند. بنابراین، همین حالا برای کشف دنیای جذاب و گسترده ی محتواهای مرتبط با "آشنایی با مدل های ترنسفورمر (Transformers) در NLP"، کلیک کنید.